Tagging、Folksonomy というコンテクスト

tag がずいぶんと浸透してきた。自分のブログの記事や flickr の写真を整理するため、検索できるようにするために、ユーザが自発的にそれらにラベル付けをする行為。それが tagging。自分のコンテンツでなくても、ニュース記事や動画に思いついたラベル付けをするスタイルの tagging もある(こちらを前例と区別して「social tagging」と言う)。この tag や tagging という行為について少し考えてみよう。

tag がずいぶんと浸透してきた。自分のブログの記事や flickr の写真を整理するため、検索できるようにするために、ユーザが自発的にそれらにラベル付けをする行為。それが tagging。自分のコンテンツでなくても、ニュース記事や動画に思いついたラベル付けをするスタイルの tagging もある(こちらを前例と区別して「social tagging」と言う)。この tag や tagging という行為について少し考えてみよう。

動画や写真など、現在のテキスト中心の検索技術では検索しにくいファイルには、tag は非常に有効な検索支援になる。先般閉店となってしまった大勝軒で食べた「つけ麺」の写真を写真共有サイトに投稿するときだったら、「大勝軒」、「つけ麺」、「池袋」などの tag を付与するなんてこともあるだろう。この tag が付与されているおかげで、「池袋」の「大勝軒」で食べた最後の「つけ麺」を撮影した「img128.jpg」※といった無味乾燥なファイル名の画像が「池袋」や「大勝軒」、「つけ麺」という文字列で検索可能になる。これらの tag がなければ、flickr にアップされた無数の写真の中から大勝軒のつけ麺の写真を探すなんてことは、ほぼ不可能に近い。

この写真の場合、「鹿島鉄道」、「八木蒔駅(やきまき)」、「キハ602」、「キハ714」といった tag が付与されている。被写体に関する付帯情報が tag となっている。

- 「鹿島鉄道」という運営会社の名称

- 撮影が行われた「八木蒔駅(やきまき)」という場所に関する情報

- 「キハ602」、「キハ714」という型式と車輌番号

鹿島鉄道

├(が所有する)八木蒔駅

├(が所有する)キハ602

└(が所有する)キハ714

という情報のヒエラルキーがあるのだが、これが flickr のタグとしてはフラットな状態で存在する。個々の tag の間には、(tag を付与したユーザ自身には何らかの意図があるにしても)何の関連性も意味付けも与えられていない。投稿者以外のユーザにとっては、投稿された画像と何らかの関連性が関連性があるのだろうという想像するしかない。性善説に基づいた信憑性(まったく関連性のない tag はつけないだろう……という思い)に依存することになる。

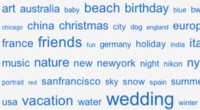

ミクロに見ればそういうことなんだけど、マクロに見ると状況はもっとおもしろい。例えば、Flickr の場合、投稿された画像の横に tag が表示されている。それをクリックすると、同じ tag でラベル付けされた他のユーザから投稿された画像を閲覧することができる。

- tag = signifiant

- 画像 = signifié

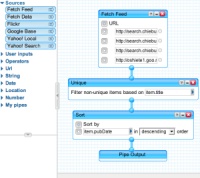

tag を語る上で、重要なコンセプトに folksonomy というものがある。簡単に説明すれば、ユーザによる分類……ということにでもなろうか。Yahoo! のディレクトリサービスへの登録作業がサーファーと呼ばれる職種の人たちによって分類され、適切なディレクトリに格納される……という例をひくまでもなく、専門家による分類はさまざまな分野でおこなわれてきた。図書館の蔵書の仕分けもそうだし、生物学上の分類もそう。権威者(オーソリティ)による分類が taxonomy であるのに対して、folksonomy の世界ではユーザにその分類の自由が与えられている。ロボット型検索エンジンによる画一的な視点ではなく、人の目を通した分類に回帰してきている現象のひとつとも考えられる。

……と書いたところで、あえてアンチテーゼ。ロボット型検索エンジンもあれでいて folksonomy な要素も持っている。検索エンジンについての解説を思いだしてもらいたい。「18歳未満」を検索文字列にした場合の検索結果。つまり、「18歳未満」(アンカーテキスト)が Yahoo! JAPAN や Disney の tag となっている……とも考えられる。作者が書き連ねたテキストが形態素解析されて、そこに含まれる内容語のひとつひとつが tag として扱われている。さらに、H1 などの HTML タグでマークアップされていれば、より重要な tag と解釈される……などと読み替えることも可能だろう。そう考えていくと、social bookmark で何人のユーザが登録してるか……という指標も、PageRank と似たようなコンセプト(どれぐらいの被リンクという指示を受けているか)と言える。

最近は少なくなったみたいだけど、Yahoo! オークションの出品者が自分の出品した商品がより多くのユーザの目に触れるように、その商品にあまり関係ないキーワードを説明文に埋め込む……というテク ニックがかなり目についた時期があった。例えば、Leica のカメラを探しているユーザが、「Leica」で検索するという場合。検索結果には、もちろん Leica も含まれるが、Leica でないクラシックカメラも含まれていたりする(いまチェックしたら、Rollei 35 がひっかかってきた)。出品者の思いとしては、「Leica に興味のある人は、きっと Rollei にも興味があるだろう」といったところだろう(どちらもドイツの高級カメラメーカー)。その商品がなぜ検索にひっかかってきたのかを見てみると、 「◆Rollei 35T ローライ Tessar40/3,5 LEICAMINOXZEISS◆」という商品名のつけ方に起因することがわかった。前半部分は、その商品そのものなんだけど、後半部分 「LEICAMINOXZEISS」が原因。これは、カメラ好きならすぐにわかるんだけど、「Leica」、「Minox」(小型カメラのメーカー)、 「Zeiss」(ドイツの有名なレンズメーカー)をくっつけて書いたもの。これも出品者の tagging であることは言うまでもないだろう。あまりにも無関係な tag(例えば、「Leica」で検索したのに「綾波レイのフィギュア」なんてのが検索結果に上がってくるとか……さすがにないか)が横行すると、検索機 能がその機能を果たせなくなり、サービスレベルの低下につながってしまうが、この程度の tag であれば、全然許容範囲。

こう考えていくと、tagging、folksonomy の面白さって、ユーザにその自由が与えられていることに尽きるのかもしれない。そうした自由の中から見いだされる関連性と意外性。大量の signifiant と signifié を処理することで、何らかの特性みたいなものが浮かび上がってくるんじゃないのかな。

※無作為に「img128.jpg」というファイル名をサンプルにしてみたけど、意外にも自分の写真にも「img128.jpg」というファイル名の写真をアップしてたことに気づいた。。。さすがに「つけ麺」じゃないけど。